GPT-5 y las nuevas reglas para trabajar con inteligencia artificial

GPT-5 marca un antes y un después, especialmente para quienes no dominan el prompting avanzado. Para usuarios que emplean instrucciones breves o poco estructuradas, el cambio es evidente: GPT-5 interpreta más, decide más y simplifica la interacción. Sin embargo, para quienes ya conocen y aplican técnicas avanzadas de prompting, el impacto es distinto. Si incorporas instrucciones precisas y bien secuenciadas, el modelo las sigue con fidelidad, manteniendo el control en tus manos. Durante sus primeros días tras el lanzamiento, la respuesta no siempre fue así: había fallos en la interpretación secuencial, pero ahora todo vuelve a funcionar con rapidez y precisión. GPT-5 puede tomar la iniciativa cuando lo necesitas, pero también respeta el mando si le das órdenes claras.

Y aquí llega el nuevo giro de guion: junto a GPT-5, OpenAI ha recuperado los modelos anteriores, desde GPT-4.5 hasta el o3 original. Esto amplía las opciones para elegir la “personalidad” de tu IA… pero también añade una capa extra de complejidad. Ahora no solo decides cuánto margen darle a GPT-5, sino también si tu tarea encaja mejor con un modelo legacy. En este nuevo escenario, la clave no es solo adaptarse, sino decidir conscientemente cuándo dejarle margen, cuándo dirigir cada paso y, ahora también, qué modelo poner al volante.

El 7 de agosto de 2025 no fue un lanzamiento más: fue el día en que GPT-5 redefinió la experiencia de trabajar con inteligencia artificial. No hablamos solo de un modelo más rápido o preciso, sino de un cambio profundo que transforma no solo lo que la IA puede hacer, sino también cómo interactuamos con ella. Siguiendo una línea similar a la propuesta de Gemini, GPT-5 simplifica la elección para el usuario: solo dos modelos disponibles, eliminando la necesidad de decidir entre múltiples versiones. Para el usuario ocasional, esto es una mejora clara: menos decisiones técnicas, más resultados inmediatos. Pero 5 días más tarde recula y recupera los modelos anteriores y, a mi parecer, complica nuevamente el escenario.

A mi parecer, se han apresurado en la recuperación de todos los modelos. Eso hace dudar más al usuario, que ahora no sabe si debe volver a usar los modelos anteriores porque son mejores, y además surge la incógnita de por cuánto tiempo se mantendrán. No vaya a ser que vuelvas a los de antes y luego desaparezcan otra vez. Estas decisiones deberían meditarse un poco más: recuperar el 4o, lo entendería más o menos… pero no recuperar todos de golpe.

El lanzamiento de GPT-5 pintaba como la oportunidad perfecta para simplificar la experiencia. Su arquitectura unificada y el enrutador de decisiones en tiempo real permiten que el modelo tome muchas decisiones internas de forma automática, liberando al usuario de ajustes técnicos innecesarios. Para quienes dominan el prompting estructurado, tanto en el chat como en los Custom GPTs, el control sigue intacto: las instrucciones avanzadas se cumplen con precisión milimétrica.

La gran novedad es que ahora tenemos más herramientas para experimentar: instrucciones adicionales que pueden aplicarse en funciones como la búsqueda profunda o el ChatGPT Agent, lo que abre puertas para guiar cómo el modelo razona, gestiona información o adapta su interacción a contextos complejos. Sin embargo, esta promesa de simplicidad convive con un menú cada vez más extenso por el regreso de todos los modelos anteriores, también en los Custom GPTs. Esto amplía las opciones, sí, pero también diluye la claridad que GPT-5 traía de serie. El reto ahora no es solo aprender a aprovechar sus nuevas capacidades, sino también navegar un catálogo que, lejos de reducirse, vuelve a pedir al usuario que elija, compare y adivine cuál es el mejor modelo para cada tarea.

Independientemente de la recuperación de los modelos anteriores, vamos a centrarnos en las características de este nuevo modelo GPT-5.

La gran novedad: arquitectura unificada

Si hay algo que define a GPT-5, es su nueva arquitectura unificada utilizando el modo «Auto». Esto significa que, en lugar de elegir entre múltiples modelos según la tarea, ahora trabajas siempre con un único sistema que decide, en tiempo real, la mejor combinación de recursos para darte la respuesta más precisa y útil posible.

En la práctica, esto se traduce en menos fricción: no tienes que pensar si tu petición requiere un modelo rápido, uno más preciso o uno especializado en código. Simplemente lanzas tu prompt, y GPT-5 se encarga de todo. Es como pasar de conducir un coche con caja manual a uno automático con asistente inteligente que sabe cuándo acelerar, frenar o tomar un atajo.

Pero aquí está la parte interesante: para que esta “magia” ocurra, el modelo unifica capacidades que antes estaban separadas. Antes, un usuario avanzado podía lanzar un prompt con un modelo como el 4o, luego pasarlo al o3, y así optimizar cada paso con distintos enfoques. Ahora seguimos pudiendo alternar, pero dentro de un ecosistema unificado de GPT-5, eligiendo según la necesidad: «Auto» para que decida el enrutador por nosotros, «Rápido» para combinar precisión, contexto y creatividad; «Thinking» cuando queremos un razonamiento profundo paso a paso; o «Pro» que ser convierte en el modelo más avanzado. El control sigue estando ahí, solo que ahora se ejerce eligiendo la “personalidad” adecuada del modelo en lugar de cambiar entre arquitecturas diferentes. Personalmente, y dentro de lo posible, voy a abandonar los modelos anteriores.

¿Por qué OpenAI hizo este movimiento? Porque la mayoría de las personas no quiere aprender a manejar una compleja “central de mandos” para obtener un buen resultado. Quieren algo que funcione bien desde el primer intento. Y en eso, la nueva arquitectura de GPT-5 brilla: simplifica la experiencia y reduce la curva de aprendizaje, democratizando el acceso a resultados de alto nivel.

Sin embargo, considero que recuperar todos los modelos anteriores en tan pocos días ha sido un error. Si realmente quieres hilar tan fino eligiendo cada modelo para cada tarea, lo lógico es trabajar en un entorno de desarrollo y hacerlo mediante el uso de APIs, donde ese control tiene sentido y aporta valor. Para la mayoría de usuarios, esta avalancha de opciones no es una ventaja: es ruido que enturbia una experiencia que, con GPT-5, había empezado a ser más clara y directa.

Mejoras clave de GPT-5

Más allá de los titulares sobre benchmarks y velocidad, la auténtica joya de GPT-5 está en su enrutador de decisiones en tiempo real. Este sistema funciona como un “cerebro orquestador” que, en fracciones de segundo, decide cómo atacar cada petición: cuántos pasos seguir, qué técnicas usar, cuánta memoria consultar y qué nivel de razonamiento aplicar.

Antes, tú tenías que elegir manualmente el modelo: uno rápido, otro más preciso, otro para código… Ahora el modelo analiza tu prompt, evalúa su complejidad y selecciona la mejor estrategia de procesamiento sin que tú muevas un dedo. Esto significa:

- Para el usuario ocasional, menos fricción y más resultados inmediatos.

- Para el usuario avanzado, adaptarse a que el control fino ya no está en sus manos… salvo que use las nuevas instrucciones para recuperar parte de esa precisión.

- Para OpenAI, menos desperdicio de potencia: ya no se ejecuta el “motor más grande” para tareas simples, lo que optimiza costes y hace un uso más inteligente de recursos.

Y es este enrutador el que potencia el resto de mejoras:

Reducción drástica de alucinaciones

Uno de los grandes dolores de cabeza en IA era la confianza: modelos que escribían con seguridad… incluso cuando inventaban. En GPT-5, la tasa de error factual ha bajado a un 4,8 % en uso general (y solo un 1,6 % en salud), frente al 20–22 % anterior. Esto significa que si antes revisabas cinco datos de cada diez, ahora revisas uno. Para periodistas, analistas o departamentos legales, es una mejora que ahorra horas de trabajo.

Mayor velocidad de respuesta

El modelo responde más rápido no porque “corra más”, sino porque es más inteligente al decidir qué pasos omitir cuando no aportan valor. Es como tener un equipo que sabe cuándo hacer un informe detallado y cuándo basta con un correo breve. En procesos internos, esta agilidad se traduce en menos tiempo de espera y mayor capacidad de iterar.

Excelencia en codificación y agentes

Aquí GPT-5 brilla. Imagina pedirle: “Crea una app web que se conecte a una base de datos, gestione usuarios y tenga un panel de administración”. Antes recibías bloques de código para unir tú mismo; ahora te entrega un proyecto completo, detecta errores y hasta te propone mejoras. En tareas agénticas, encadena decenas de llamadas a herramientas para ejecutar un plan complejo: desde recolectar datos, analizarlos y generar visualizaciones, hasta integrarlos en un informe final. Los números lo respaldan: SWE-bench Verified (74,9 %) y Aider Polyglot (88 %) son pruebas de que, en desarrollo de software, juega en la liga más alta.

Razonamiento y comprensión de contexto

GPT-5 entiende mejor lo que le pides… incluso lo que no le dices. Analiza el contexto, anticipa necesidades y detecta incoherencias antes de responder. En una licitación pública, por ejemplo, puede señalar que falta un documento clave; en un plan de marketing, que no has definido un KPI esencial. Esto no solo ahorra pasos, sino que eleva la calidad de los resultados.

Salud

En el ámbito médico, GPT-5 ha dado un salto notable. No se limita a contestar: identifica riesgos potenciales, hace conexiones entre síntomas y datos, y es proactivo a la hora de alertar sobre posibles problemas. Para consultas complejas o análisis de casos, esto significa un apoyo más fiable y seguro, aunque siempre como complemento, no sustituto, del criterio clínico.

Modo de voz avanzado

No es solo “voz” como asistente telefónico; es conversación natural en tiempo real. Puedes, por ejemplo, mantener una reunión con GPT-5 como si fuera un colega experto, pedirle que resuma en directo lo que se está diciendo y que, al acabar, genere un acta estructurada. La integración en GPTs personalizados lo convierte en un canal más para interactuar con la IA sin necesidad de estar frente a un teclado.

Ventana de contexto ampliada (API)

En la API, ahora puedes trabajar con hasta 400K tokens de contexto, con rendimiento SOTA en 128K y 258K. ¿Qué significa? Que puedes cargar un informe técnico, un contrato de cientos de páginas o una base de datos textual masiva… y seguir trabajando sobre todo ese material como si estuviera “en la cabeza” del modelo. Esto evita fragmentar la información y mejora la coherencia de las respuestas.

Seguridad y safe completions

El modelo es más difícil de manipular y más inteligente en sus bloqueos: ya no se limita a decir “no puedo responder”; puede dar una respuesta parcial, explicar por qué no puede entrar en ciertos detalles y ofrecer alternativas seguras. Esto es clave para entornos donde la IA interactúa con el público, como chatbots corporativos o atención ciudadana.

En resumen, GPT-5 no solo añade potencia, sino que reorganiza su inteligencia para darte mejores resultados con menos intervención. El reto para el usuario avanzado será aprender a hablarle con precisión usando las nuevas instrucciones… y ahí es donde el siguiente punto, sobre su capacidad agéntica, se vuelve fundamental.

Capacidad agéntica: de responder a ejecutar

Si hasta ahora veíamos a la inteligencia artificial como un asistente brillante que te daba respuestas rápidas, con GPT-5 entramos en la era del colaborador autónomo. Y la palabra clave aquí es agéntico: la capacidad de no solo responder, sino de diseñar un plan, ejecutarlo y coordinar múltiples pasos o herramientas hasta llegar al objetivo final.

Imagina que le pides a GPT-5: “Analiza las estadísticas de turismo del último año, identifica las tres tendencias más relevantes y crea una propuesta de campaña digital para atraer visitantes internacionales, con un presupuesto de 20.000 €”. En versiones anteriores, recibirías un buen análisis y un borrador de ideas. Con la capacidad agéntica, el modelo:

- Recopila datos desde varias fuentes autorizadas (si tiene acceso o mediante integraciones).

- Procesa esa información, detecta patrones y los valida.

- Diseña una estrategia de campaña alineada con el presupuesto.

- Propone un calendario de ejecución y herramientas recomendadas.

- Incluso, si está integrado con tus sistemas, puede dejar configuradas las primeras piezas de la campaña.

Ahora bien, si eres de los que dominaban el prompt secuencial, esa técnica de desglosar una tarea en pasos claros, desarrollando cada instrucción fase por fase, notarás que el salto no es tan radical. Con GPT-5 puedes entrar en más detalle y obtener razonamientos más profundos en cada fase, pero la lógica de trabajo sigue siendo muy parecida: tú defines el camino, el modelo lo recorre contigo. La diferencia es que ahora puede encargarse de más subpasos sin que tengas que escribirlos explícitamente.

Y aquí surge una pregunta natural: ¿No es eso lo que ya hacían los modelos anteriores con ChatGPT Agent? La respuesta es que, en esencia, sí: ChatGPT Agent ya era capaz de ejecutar cadenas de acciones. La diferencia es que con GPT-5 esta capacidad está más integrada en el núcleo del modelo, sin necesidad de activar un modo separado o configurar tanto. Dicho de otro modo, lo que antes era una función “especial” ahora está embebido en la experiencia estándar, aunque sigue habiendo un terreno en el que ChatGPT Agent brilla más: la coordinación de múltiples agentes o estrategias paralelas para resolver un problema.

Cómo incorporar las nuevas instrucciones de GPT-5 en un prompt

Con la arquitectura unificada de GPT-5, muchas decisiones internas se gestionan de forma automática mediante su enrutador de decisiones. Para quien no utiliza prompts muy avanzados, esto es una gran mejora: menos configuraciones, menos fricción y mejores resultados por defecto. Pero para quienes ya dominan el diseño de prompts, GPT-5 trae un regalo añadido: nuevas opciones de sintaxis y meta-instrucciones que amplían las posibilidades de control. Estas indicaciones, que en la mayoría de los casos se colocan en la sección #AJUSTES, permiten afinar el nivel de razonamiento, definir cómo gestionar errores, ajustar el formato de salida, modular el tono, adaptar el estilo de interacción o incluso decidir el tiempo que el modelo debe dedicar a la tarea. En la práctica, funcionan como un “panel de mandos” avanzado para guiar de forma precisa cómo GPT-5 piensa, responde y entrega resultados.

Etiquetas clave incorporadas por OpenAI

<reasoning_effort> Controla el nivel de razonamiento antes de responder.

- Effort level: very low | low | medium | high

- Breakdown steps: detallar pasos intermedios (yes/no)

- Validation: verificar conclusiones (yes/no)

- Alternate paths: explorar varias hipótesis (yes/no)

- Stop criteria: condición para detener el análisis

Uso: Ajusta profundidad vs velocidad según la tarea.

<error_handling> Define qué hacer ante errores o falta de información.

- Strategy: retry | suggest_alternative | skip_step

- Detail_level: summary | detailed

Uso: Evita bloqueos y mantiene la entrega de resultados útiles.

<time_allocation>

Orienta la “paciencia” del modelo en la tarea.

- Mode: rápido | equilibrado | exhaustivo

Uso: Indica si debe priorizar velocidad o profundidad.

Ejemplo completo de prompt con meta-instrucciones

# ROL

Consultor estratégico en transformación digital y marketing para empresas agroindustriales.

# PÚBLICO

Directores de empresas productoras y exportadoras de aceite de oliva en España, interesados en expandir su presencia en mercados internacionales.

# CONTEXTO

La empresa ha experimentado un descenso del 12% en ventas internacionales durante el último año debido a la competencia de nuevos actores y a cambios en la demanda. Se dispone de un presupuesto de 15.000 € para una estrategia digital de relanzamiento.

# TAREA

Analizar datos recientes del mercado global del aceite de oliva, identificar tres segmentos de alto potencial y diseñar una estrategia digital con acciones específicas para cada segmento, incluyendo estimación de impacto y presupuesto asignado.

# PRESENTACIÓN

Informe en formato tabla con columnas: «Segmento objetivo», «Acción recomendada», «Canal», «Presupuesto estimado», «Impacto previsto».

# AJUSTES

<reasoning_effort>

– Effort level: high

– Breakdown steps: yes

– Validation: verify each step

– Alternate paths: explore

</reasoning_effort>

<error_handling>

– Strategy: suggest_alternative

– Detail_level: summary

</error_handling>

En este ejemplo, las etiquetas de #AJUSTES indican al modelo que debe trabajar con un razonamiento profundo, validando cada paso, proponiendo alternativas si algo falla y entregando el resultado en formato tabla. Esto devuelve al usuario avanzado la capacidad de guiar a GPT-5 con la precisión que antes tenía al elegir y configurar modelos.

Recursos

Optimizer for GPT-5: https://platform.openai.com/chat/edit?models=gpt-5&optimize=true

GPT-5 prompting guide: https://cookbook.openai.com/examples/gpt-5/gpt-5_prompting_guide

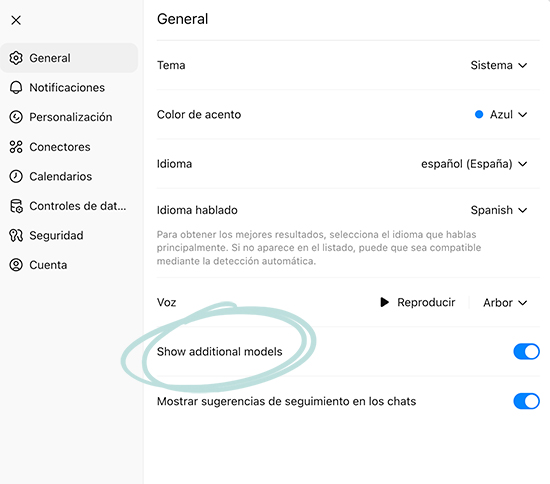

Selector de modelos con GPT-5 y los modelos anteriores

El selector de modelos de ChatGPT vuelve a ser protagonista. OpenAI ha reactivado la opción “Show additional models”, rescatando todos los legacy models: GPT-4o, GPT-4.1, o3-pro, GPT-4.5, 04-mini-high, GPT-4.1-mini, o3 y 04-mini. Y junto a ellos, los nuevos destacados bajo GPT-5: Auto, Rápido, Thinking y Pro.

¿Por qué este movimiento? La comunidad pedía más control y menos “caja negra” en el enrutado automático. Muchos usuarios valoraban el carácter cálido, rápido y multimodal de GPT-4o, que contrastaba con el enfoque más automatizado de GPT-5 Auto. Así, OpenAI cede terreno a la personalización y recupera ese “toque humano” en la experiencia.

- GPT-5 Auto: El piloto automático de la IA. Es como decirle: “Tú decides”. Elige por ti el modelo que considera óptimo para cada tarea. Ideal si buscas comodidad y rapidez sin romperte la cabeza. Eso sí, sacrificas un poco de control manual… aunque aquí está el truco: con la etiqueta <reasoning_effort> puedes indicarle cuánta “gasolina mental” quieres que ponga en cada respuesta. Un guiño sencillo para pasar de un modo exprés a un análisis más profundo cuando realmente lo necesitas.

- GPT-5 Rápido: La esencia del histórico GPT-4o: cálido, ágil, multimodal y con baja latencia. Perfecto para interacción fluida en texto, voz e imagen.

- GPT-5 Thinking: La evolución del espíritu “o3”: razonamiento profundo, más tiempo de cálculo y foco en precisión. Ideal para problemas complejos y análisis detallados.

- GPT-5 Pro: El equivalente moderno del “o3-pro”: músculo y rendimiento para proyectos exigentes, con mayor capacidad de procesamiento y consistencia en resultados.

- Legacy models: Los clásicos que nunca mueren. Desde GPT-4.5 hasta el o3 original, todos disponibles de nuevo para quienes prefieren lo probado y familiar. En mi lectura, este nuevo selector plantea más dudas que certezas: la diferencia real entre GPT-5 Rápido y GPT-4o es difusa, y el regreso de todos los legacy puede confundir más que ayudar. Y ojo, que la cosa se complica todavía más: en los custom GPTs también se han recuperado los modelos anteriores, así que ahora tienes un buffet libre de IA… pero con el riesgo de no saber cuál elegir. Uno de los objetivos de OpenAI era simplificar, como hace Gemini reduciendo opciones, y de momento parece que vamos justo en dirección contraria.

En mi lectura, este nuevo selector plantea más dudas que certezas: la diferencia real entre GPT-5 Rápido y GPT-4o es difusa, y el regreso de todos los legacy puede confundir más que ayudar. Y ojo, que la cosa se complica todavía más: en los custom GPTs también se han recuperado los modelos anteriores, así que ahora tienes un buffet libre de IA… pero con el riesgo de no saber cuál elegir. Uno de los objetivos de OpenAI era simplificar, como hace Gemini reduciendo opciones, y de momento parece que vamos justo en dirección contraria.

El ecosistema y las integraciones

El lanzamiento de GPT-5 no llega en solitario: viene acompañado de un ecosistema de integraciones que, en muchos casos, ahora pueden explotar de verdad las capacidades del modelo gracias a la arquitectura unificada, la capacidad agéntica y las meta-instrucciones.

Antes, muchas de estas conexiones estaban infrautilizadas porque el usuario debía indicarle al modelo cada paso y, en la práctica, se perdía agilidad. Ahora, GPT-5 puede decidir cuándo y cómo utilizar esas integraciones de forma autónoma, y ahí está la gran diferencia.

Integraciones disponibles y anunciadas con GPT-5:

- Cursor: Calificado por la plataforma como “el modelo más inteligente” que han utilizado, integrado para mejorar la generación y edición de código.

- Lovable: Incorporación del modelo para acelerar la creación de software en su entorno de desarrollo.

- Google Workspace: Conexión inicial con Gmail y Google Calendar, actualmente en despliegue para usuarios Pro.

- Microsoft 365: Integración en Microsoft Copilot, Microsoft 365 Copilot, GitHub Copilot y Visual Studio Code. Disponible también en Azure AI Foundry.

- Apple: Prevista la integración en iOS, iPadOS y macOS, incluyendo Siri, herramientas de escritura y Visual Intelligence, con limitaciones por tipo de modelo.

- Snowflake: Conectores seguros que permiten trabajar con datos dentro del perímetro empresarial.

- Databricks: Conexión directa para análisis y procesamiento de datos en entornos corporativos.

GPT-5 marca un nuevo punto de inflexión. No solo por su potencia bruta, sino porque redefine la relación entre usuario y modelo:

- Con la arquitectura unificada, ya no tienes que preocuparte por qué modelo elegir.

- Con la capacidad agéntica, no solo responde: ejecuta y coordina.

- Con las meta-instrucciones, puedes recuperar el control fino que antes tenías sobre el flujo de trabajo.

Es un cambio que beneficia a todos, pero que premia especialmente a quienes están dispuestos a entender cómo hablarle al modelo y cómo integrarlo en procesos reales. La diferencia entre “usar GPT-5” y “sacarle todo el partido” no está en la tecnología, sino en cómo la diriges.

Conclusiones personales sobre GPT-5: lo que realmente cambia

Después de sumergirme a fondo en GPT-5, mi sensación es clara: no es simplemente “un modelo nuevo y más potente”. Es un cambio que redefine la forma en que interactuamos con la IA. Para el usuario ocasional, todo resulta más sencillo y directo, con menos fricción y mejores resultados sin esfuerzo. Para el usuario avanzado, la novedad está en la incorporación de nueva sintaxis y meta-instrucciones que podemos emplear para afinar aún más el comportamiento del modelo, adaptándolo a nuestros propios métodos y objetivos.

No es solo un salto de versión

En otros lanzamientos, la dinámica era relativamente sencilla: probabas el modelo, comprobabas que respondía mejor que el anterior y seguías trabajando casi igual. Esta vez no. Mi flujo de trabajo se ha alterado porque ya no tengo que hacer benchmarking entre una multitud de modelos; ahora todo se concentra en cuatro opciones claras: GPT-5 Auto, GPT-5 Rápido, GPT-5 Thinking y GPT-5 Pro. Esto simplifica la elección, pero también implica ajustar cómo planteo y pruebo mis prompts para aprovechar al máximo cada uno de ellos. Dentro de lo posible voy a ignorar la recuperación de los modelos anteriores.

Un avance… ¿para quién?

Se ha presentado GPT-5 como un gran paso adelante para el usuario. Y sí, lo es… pero de forma distinta según el perfil. Para quien no quiere complicarse, ahora es más fácil: menos opciones, más resultados inmediatos. Para el usuario avanzado, la historia cambia: no hemos perdido control, pero sí ha cambiado la forma de ejercerlo. Antes podía forzar ciertos comportamientos internos saltando entre diferentes modelos; ahora, gran parte de esas decisiones se concentran en cuatro variantes (GPT-5 Auto, Rápido, Thinking y GPT-5 Pro) y en las nuevas meta-instrucciones que puedo incluir en los prompts. El control sigue ahí, pero se ha reordenado.

La nueva sintaxis de prompts

OpenAI ha introducido una nueva sintaxis que, oficialmente, está más pensada para desarrolladores. Sin embargo, podemos incorporarla en la sección de #AJUSTES de nuestros prompts para afinar el comportamiento del modelo. Aún me queda mucho por probar para medir su impacto real y ver si, en la práctica, GPT-5 las sigue de forma consistente.

Siguiendo el camino de Gemini (pero no)

Simplificar la experiencia con un solo modelo —GPT-5 y sus variantes— me parecía una decisión muy acertada para la mayoría de usuarios. Si lo que buscas es seleccionar quirúrgicamente qué modelo utilizar en cada momento, lo lógico es pasarte al entorno de desarrollo con APIs, donde tienes todo el catálogo disponible y un control absoluto. En este sentido, con la recuperación de los modelos anteriores en ChatGPT, Gemini recupera parte de su ventaja competitiva: su chatbot simplifica para el usuario ofreciendo solo dos modelos, pero si entras en aistudio.gemini.com puedes trastear con todo su elenco y, cuando ya tengas claro qué quieres, dar el salto al entorno de desarrollo en Google Cloud.

La adaptación no es inmediata

En su lanzamiento, mi impresión no fue positiva. Durante los dos primeros días, los resultados con los prompts que ya tenía diseñados no estaban a la altura. No sé si fue un problema del enrutador o algo más, pero algo no encajaba. Tres días después, todo empezó a funcionar bien… y justo entonces llegó la sorpresa: ante la crítica masiva de la comunidad, OpenAI decidió recuperar todos los modelos anteriores. El resultado: un escenario mucho más confuso para la mayoría de usuarios.

Mi consejo es claro: céntrate en GPT-5. Aprovecha su nueva sintaxis, su mayor capacidad de razonamiento y el uso ampliado de herramientas. Si lo que buscas es hilar fino eligiendo modelos, mejor pásate al entorno de desarrollo con APIs; pero si lo que quieres es trabajar con rapidez y consistencia, GPT-5 es el camino.

Mejoras en interfaz… menores

El rediseño de la interfaz aporta detalles como los chats en diferentes colores, algo simpático pero anecdótico. No es ahí donde está el cambio profundo, aunque ayuda a personalizar la experiencia.

Optimización de costes para OpenAI

No hay que pasar por alto un aspecto estratégico de este movimiento de OpenAI: también es una optimización de costes. Antes, muchos usuarios enviaban cualquier tarea —por simple que fuera— al modelo más avanzado, asumiendo que siempre era la mejor opción, aunque eso implicara un uso innecesario de recursos computacionales, más costosos para la compañía. Con GPT-5 como modelo principal y sus variantes, se incentiva que cada tarea se ejecute con la potencia justa, reservando el modelo más exigente para los casos que realmente lo requieren.

El problema es que, tras la recuperación de todos los modelos anteriores, esa claridad inicial se ha perdido. Volvemos a un escenario donde el usuario no solo debe decidir cuándo usar GPT-5 Rápido o GPT-5 Razonamiento, sino también si alguno de los legacy encaja mejor. Esto no solo complica la experiencia, sino que podría ir en contra de esa optimización de costes que la arquitectura unificada buscaba.

Una oportunidad de entrenamiento para OpenAI (ocasión desaprovechada)

Este cambio, más allá de las mejoras visibles, podía haber sido una gran oportunidad para que OpenAI centralizara interacciones y entrenara mejor sus sistemas. Con una arquitectura unificada, cada prompt habría alimentado un mismo modelo, acelerando el aprendizaje y optimizando resultados. Sin embargo, la rápida recuperación de todos los modelos anteriores dispersa nuevamente esas interacciones, reduciendo el potencial de este enfoque. La idea inicial era sólida; la ejecución, en cambio, ha diluido buena parte del impacto que podía tener.

No todo es código y salud

Se ha hablado mucho del rendimiento de GPT-5 en desarrollo de software y en entornos médicos. Pero, siendo realistas, no todo el mundo es programador ni médico. Yo me muevo en el entorno empresarial y, desde esa óptica, lo relevante no es tanto que bata récords en SWE-bench, sino que pueda ayudar a implantar una cultura de IA en las organizaciones. Porque si esta tecnología no la usamos todos, de la dirección al último departamento, se queda en un nicho muy pequeño.

En resumen

GPT-5 no es simplemente “el siguiente modelo” en la cadena evolutiva, sino un rediseño profundo de cómo interactuamos con la IA. El usuario ocasional gana con menos fricción y resultados potentes por defecto. El usuario avanzado, tras un inicio que no fue brillante, ahora dispone de nuevas herramientas: sintaxis ampliada, meta-instrucciones, mayor capacidad de razonamiento y un ecosistema que, en teoría, buscaba simplificarse con GPT-5 como núcleo.

Mi recomendación es clara:

-

Adáptate a GPT-5 salvo que exista una necesidad muy específica que lo haga ineficiente para tu caso.

-

Si tienes que recurrir a un modelo anterior, que sea como mucho al GPT-4o.

-

Recuerda que no sabemos cuánto tiempo permanecerán disponibles los modelos legacy y que retirar GPT-5 no es una opción.

-

Es razonable pensar que, con el tiempo, los modelos antiguos se irán diluyendo y GPT-5 se afinará hasta satisfacer a la mayoría de usuarios.

Porque el verdadero salto con GPT-5 no es técnico: es de mentalidad. Los que antes éramos “buenos prompteadores” tendremos que demostrar que también sabemos adaptarnos a un modelo que redefine las reglas del juego. La estrategia más sensata para la mayoría es centrarse en GPT-5, aprovechar su arquitectura unificada y permitir que sea el estándar sobre el que OpenAI siga construyendo.

Debate abierto: recuperación de modelos en GPT-5

Tercera vez que tengo que reescribir mi post sobre GPT-5.

💬 Preguntas para vosotros:

-

¿Creéis que era buena idea recuperar TODOS los modelos anteriores?

-

¿Y si solo hubieran traído de vuelta el 4o?

-

¿Hasta cuándo creéis que se mantendrán?

-

¿Hay alguna posibilidad de que GPT-5 se retire? Si no es así… ¿para qué seguir con los anteriores?

-

La simplificación de la experiencia parecía una gran decisión para la mayoría de usuarios. Si quieres elegir quirúrgicamente un modelo… ¿no crees que lo suyo es desarrollar con el API?

-

¿Has visto algún prompt que antes te funcionaba y ahora no con GPT-5?

-

Admito que los dos primeros días funcionaba fatal, pero una vez estabilizado… ¿has notado diferencias reales entre GPT-5 Fast y GPT-4o? ¿En qué?

Tu experiencia vale más que lo que dicen los medios. Espero tus opiniones…

2 Comentarios

Gracias Tirso. Muy interesante, como siempre.

¿Y las diferencias entre el modelo base y el THINKING?

Por lo que he podido leer (porque me cuesta ver la diferencia más allá del factor tiempo), es como tener «reasoning_effort: high» activado por defecto. Dedica más tiempo y, en teoría, ofrece un razonamiento y análisis más elaborados